已经解决 谢谢大神的指导

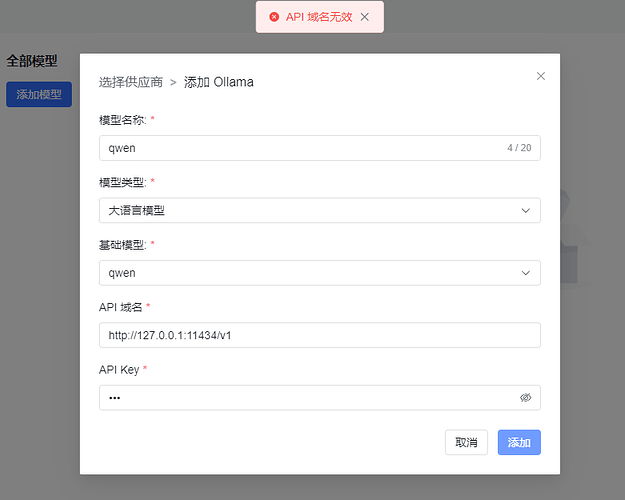

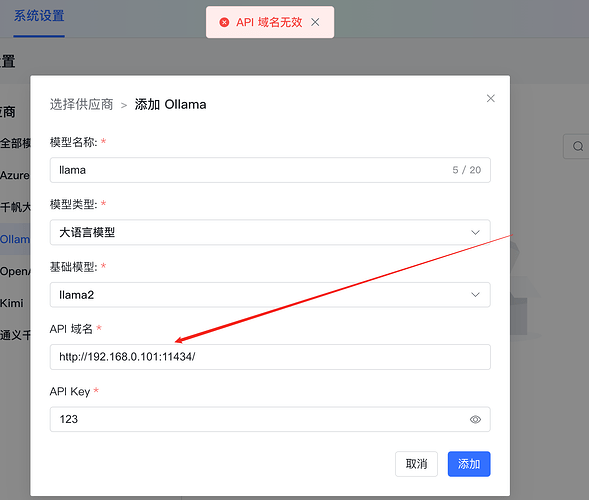

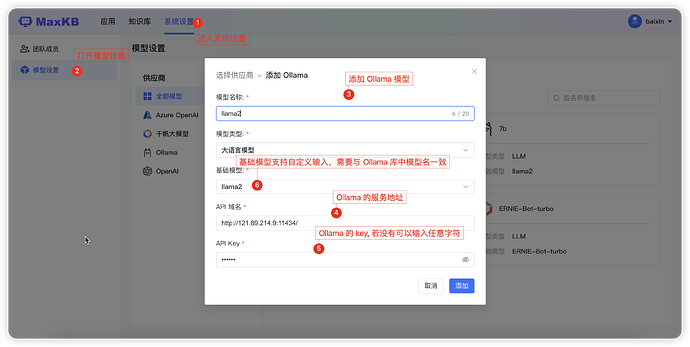

关于 添加 Ollama 模型 提示 API 域名无效的问题:

1. API 域名内容说明

MaxKB 版本为 0.9.0,API 域名格式为:http://您ollama所在服务的ip地址:您ollama的端口号/v1

MaxKB 版本为 0.9.1及之后的版本API 域名格式:http://您ollama所在服务的ip地址:您ollama的端口号/

注意:API 域名不可使用 127.0.0.1 或 localhost。

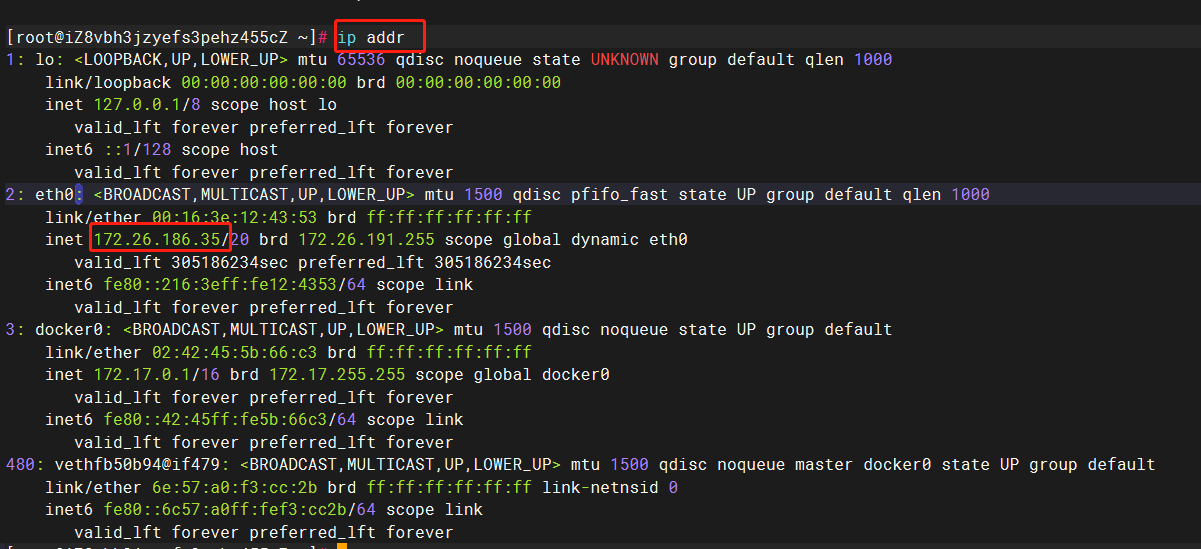

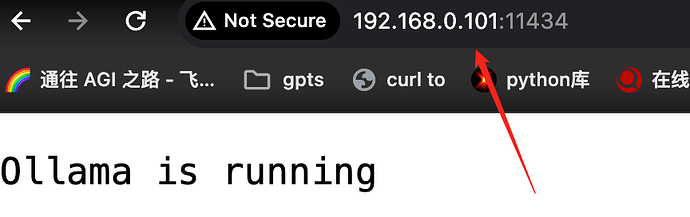

2. 获取 Ollama 服务的 IP 地址

到Ollama所在服务器上执行: ip addr , 获取到服务器的 IP地址,

如下图查询到的Ollama服务器IP 地址为 172.26.186.35,那么API 域名为:http://172.26.186.53:11434

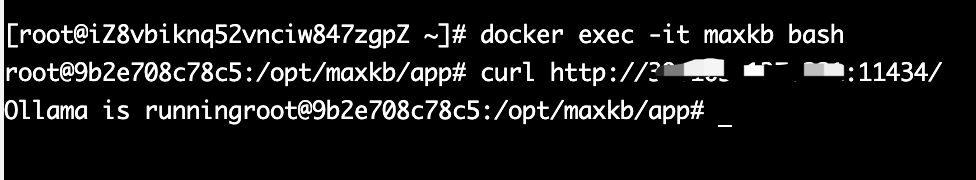

3. 确保 MaxKB 容器可正常访问Ollama服务

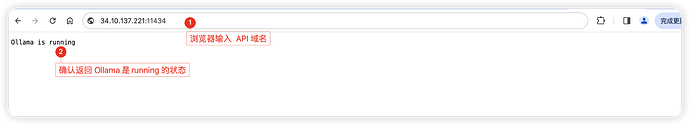

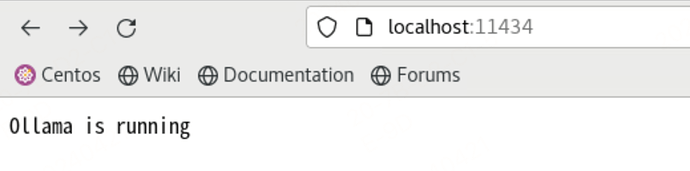

在maxkb 容器中访问 Ollama 的 API域名,确保返回 【Ollama is running 】的状态

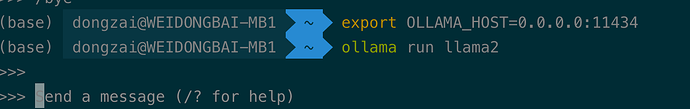

4 . Ollama配置文件修改

修改/etc/systemd/system/ollama文件,配置监听在0.0.0.0网段

增加一行:Environment=“OLLAMA_HOST=0.0.0.0”

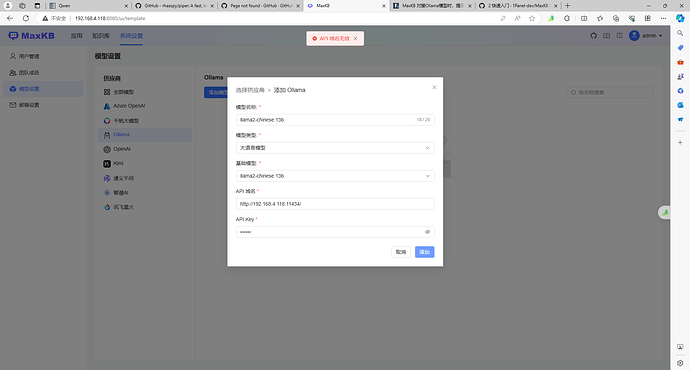

5. 以上确认无误后,再到 MaxKB 中 添加 Ollama 的模型

基础模型支持自定义输入:qwen:0.5b 然后回车、回车、回车即可。

表单如下:

1 个赞

我想问一下,这种方法确定是调用的本地模型哈?不是线上的吧?还有就是下载的模型路径在哪?

不用下载,直接在 MaxKB 的模型管理中对接 Ollama ,MaxKB会自动执行命令:ollama run 基础模型。

模型添加成功就能调用。

CMD运行:

docker run -d -p 3214:3214 -e OLLAMA_PROXY_URL=http://host.docker.internal:11434/v1 1panel/maxkb

Ollama API域名填写:http://host.docker.internal:11434

- 需要确保3214端口没有被排除了

- 端口排除范围查看:使用命令netsh interface ipv4 show excludedportrange protocol=tcp

- 如果端口包含在列表范围内,需要将3214换一个没在范围内的

- 3214只是一个举例,可用其他端口。

2 个赞

你好,按照步骤部署,添加ollama模型不行哦,还是显示api域名不可用

仔细看上面要求不能用127.0.0.1

访问不了,需要自己单独部署Ollama 吗?

你要先部署 Ollama,可以通过 1panel 部署。

可以参考以下教程:

好像不能使用 localhost~

是必须通过1Panel安装MaxKB和Ollama么?这两个我都是用命令装的,各自都能运行起来

可以使用命令安装,只要确保Ollama和 MaxKB 运行成功就行,在本帖找一下 解决方案,按照解决方案的方法修正一下。

我的已解决,看看是不是容器无法访问这个 ip,ping 一下试试。