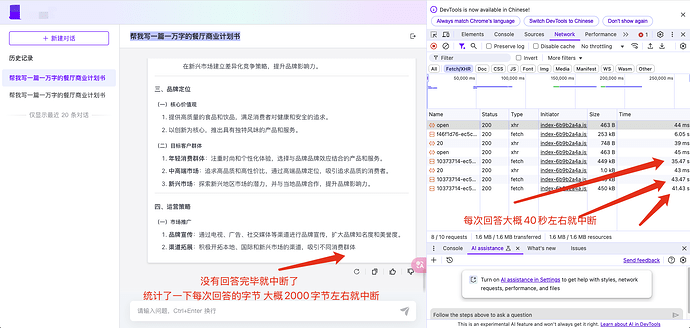

使用自己部署的 ollama 模型 deepseek-r1:1.5b

每次超过2000字节或者40秒左右就回答中断 同一个模型在 dify 中就不会中断 不清楚是什么原因

maxkb的版本是最新的版本

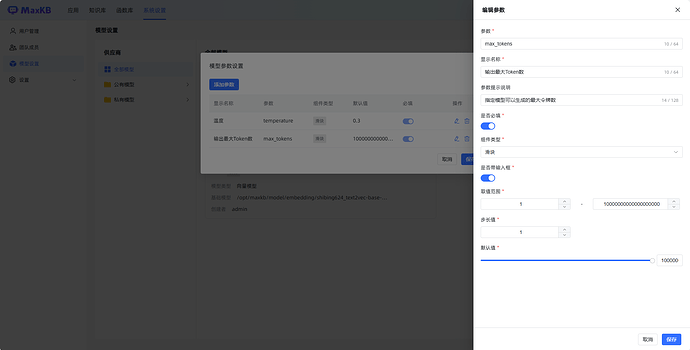

模型的Tokens参数设置是多大?

同问,模型token设置最大,还是会中断

请问您有解决吗

我也遇到了这个问题,回答被截断了,不过tokens我确实没有调整过。

有类似的问题在Github上提交了,如果确认是v1.10.1-LTS版本,并且调整了Tokens参数依旧会出现这个问题,可以在这个issue下面继续反馈。

https://github.com/1Panel-dev/MaxKB/issues/2281

后面你们解决了吗?我现在也是碰到这样的问题,没回答完就结束了,其他地方调用没有问题

已经解决了,官方说已经创建的模型不能在模型里面修改参数,不会生效。需要在应用的模块里面设置参数就可以生效了。