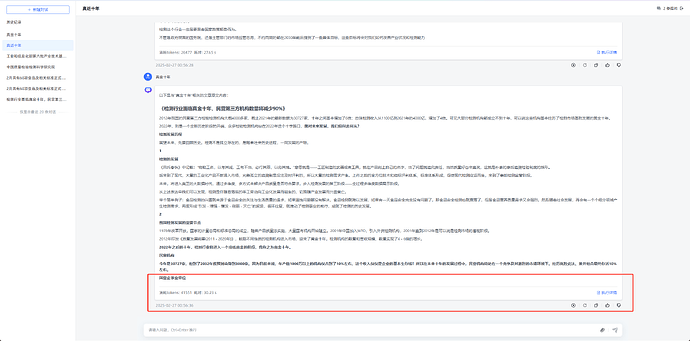

无论是命中知识库后的结果输出,还是没命中知识库的推理结果输出,都是只输出了一部分内容后就突然终止了,本地模型和API都试过,都一样的问题,请问是什么原因呢?我确定网络没有问题,maxtoken配的也没问题,API的余额也足够,输出的结果内容也远没有到达最大输出的token数,服务器配置也足够,16核,64G,两路A10

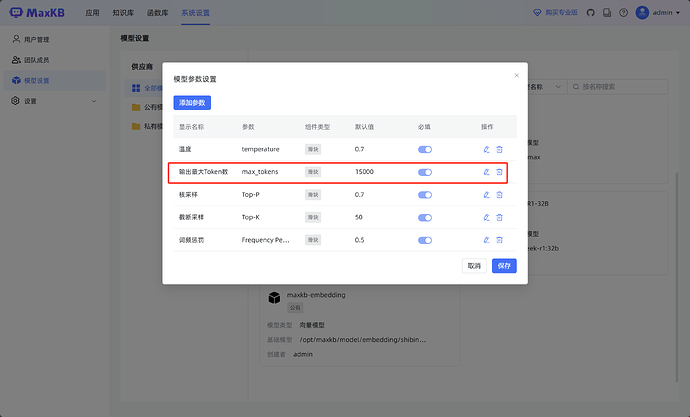

我也遇到了类似的问题,在另一个相关的帖子里看到,需要在应用设置中,手动重新调整一下最大输出token,在模型配置中调整最大输出token好像不会在应用中生效,在应用中单独调整之后输出完整了。

同问上述问题 ![]()

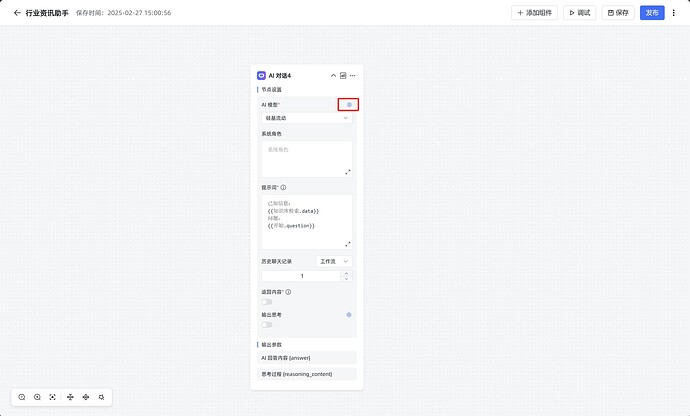

但是应用中没有最大输出token的设置项呀,请问在哪里设置呢?

已经找到了,非常感谢!

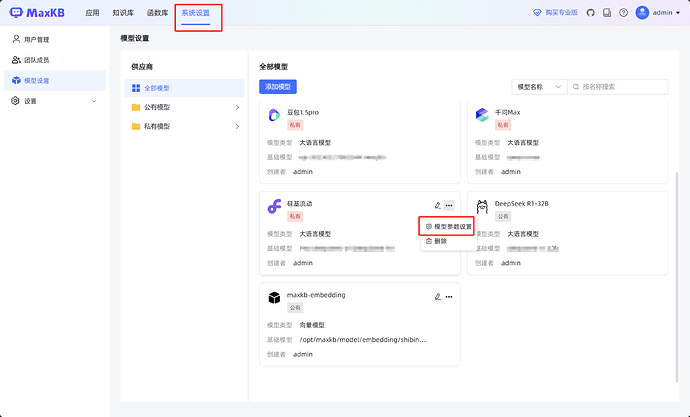

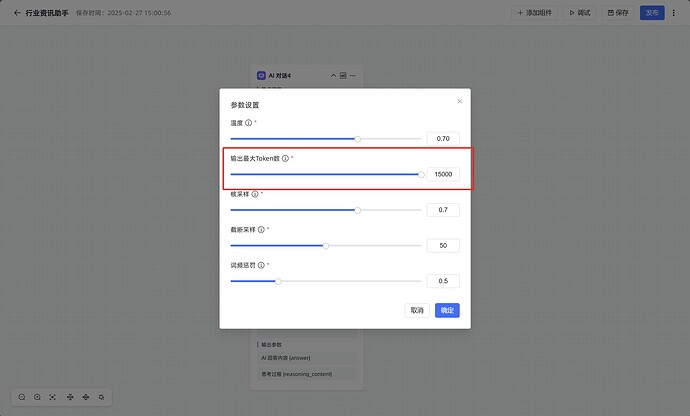

我解决了,需要在应用设置的AI对话组件框里,选择大模型的那个选择框的右上角齿轮图标,点开后可以设置最大token

麻烦问下,这个在哪里设置?我没找到,方便截个图吗?谢谢