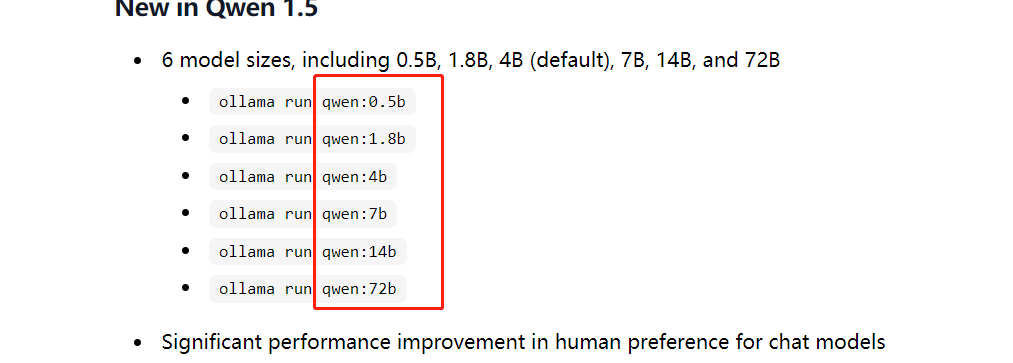

这个最小的都带不动,因为只有cpu,只有阿里的千问可以,模型大小只有300多M的:qwen:0.5b-chat,弄个小的玩玩吧,或者这个:nomic-embed-text才100M,希望加上,谢谢,适合小型服务器也能玩玩

感谢反馈,后期会新增对接其他供应商的模型,可以关注一下后期版本更新。

qwen:0.5b-chat是Ollama模型,希望Ollama的基础模型列表,是通过Ollama接口获取用户自己安装的模型列表呗

Ollama 供应商的基础模型支持 自定义输入,你可以输入 qwen:0.5b-chat 回车,系统会自动下载部署模型。

我想要的是maxKB能调用Ollama已安装的qwen:0.5b-chat模型

我知道,但是maxKB无法使用啊

有没有离线的方式安装模型

同问,好多都是离线环境

这个非常简单,从抱抱脸国内镜像下载模型后,使用ollama的命令即可安装