MaxKB 在V 1.4.0 版本之后已经支持自定义Embedding模型,那么如何对接本地Embedding模型,详细操作步骤如下:

一、下载向量模型

在对接向量模型之前,先去下载好对应的模型:https://huggingface.co/

(注意:下载模型需要使用魔法,最好使用网络稳定一点的。)

二、上传模型到服务器

下载好模型之后,上传到部署MaxKB的服务器上。

1. 创建 model 文件夹

## 创建 model 文件夹

mkdir /opt/maxkb/model

2. 修改docker-compose.yaml,添加volume挂载点

## 修改docker-compose.yaml,添加volume挂载点

version: "2.1"

services:

maxkb:

container_name: maxkb

hostname : maxkb

restart: always

image: ${MAXKB_IMAGE_REPOSITORY} /maxkb-pro :${MAXKB_VERSION}

ports:

- "${MAXKB_PORT}:8080"

healthcheck:

test : [ "CMD" , "curl" , "-f" , "localhost:8080" ]

interval: 10s

timeout: 10s

retries: 120

volumes:

- /tmp : /tmp

- ${MAXKB_BASE} /maxkb/logs : /opt/maxkb/app/data/logs

- mk-model-data: /opt/maxkb/model

env_file:

- ${MAXKB_BASE} /maxkb/conf/maxkb . env

depends_on:

pgsql:

condition: service_healthy

networks:

- maxkb-network

entrypoint: [ "docker-entrypoint.sh" ]

command : "python /opt/maxkb/app/main.py start"

networks:

maxkb-network:

driver: bridge

ipam:

driver: default

volumes:

mk-model-data:

driver_opts:

type : none

device: ${MAXKB_BASE} /maxkb/model

o: bind

## 添加完之后重新启动

docker-compose -f docker-compose.yml -f docker-compose-pgsql.yml up -d

## 等一会查看一下状态

docker ps

3. 检查mode文件夹是否有MaxKB的默认模型

4. 把下载好的向量模型放到model文件夹下

## 把下载的模型放到model当中

cp -R /opt/models--moka-ai--m3e-large /opt/maxkb/model

注意:后续下载新的模型只需要放到model文件夹下面即可。

三、配置本地向量模型

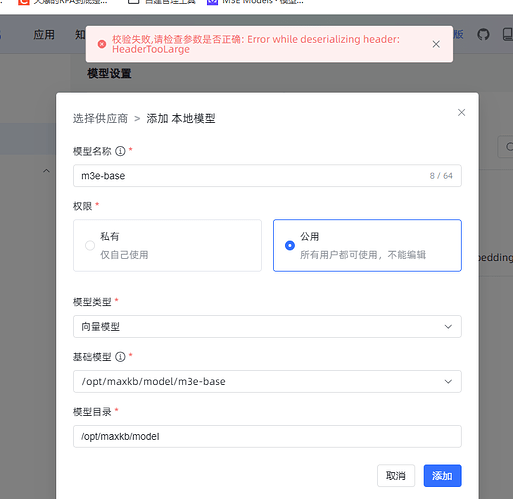

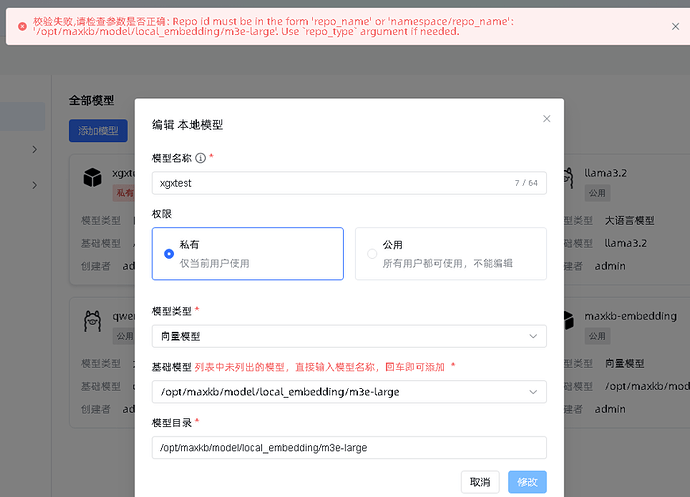

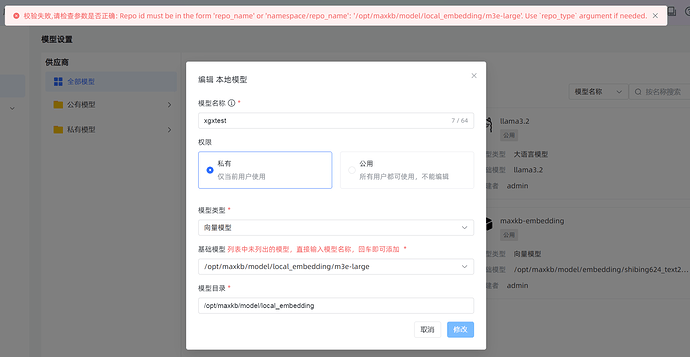

1. 添加模型

系统管理->模型设置->本地模型→"添加模型"

1.1. 参数详情:

模型名字: 自定义模型名字(填写自己模型名字就好)

模型类型: 选择“向量模型”

基础模型:此处需要注意,要手动填写对应的模型地址。

所填写的地址必须要有,pytorch_model.bin、tokenizer_config.json、tokenizer.json 等这些文件

/opt/maxkb/model/models--moka-ai--m3e-large/snapshots/12900375086c37ba5d83d1e417b21dc7d1d1f388

不同的模型,路径应该有所不同,根据实际情况修改

模型目录: 默认跟“基础模型”路径一致

添加好之后如图:

2. 使用自定义模型

在创建知识库的时候,指定向量模型即可