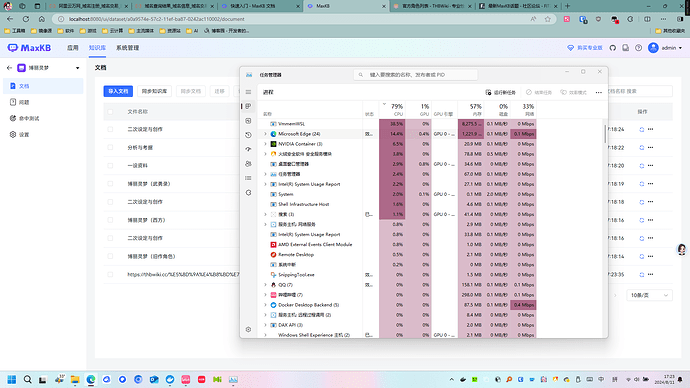

有没有什么办法让 MaxKB 在执行向量化的时候调用英伟达的显卡进行运算?我感觉 CPU 运算非常缓慢,如果能使用显卡运算的话,等的时间不用太久。

你说的很对,确实是这个情况,对话时问一个问题,先是cpu拉升的很高,最后回答的一瞬间才是GPU,CPU耗费太多时间了。我记得MaxKB的旧版本不是这样的,对话上来就是GPU运算到底,还有人说是ollama新版本的原因,到底是因为什么,搞不懂,反正回答速度降低了300%以上

向量化时不使用GPU · Issue #4819 · chatchat-space/Langchain-Chatchat · GitHub

我检索了下 Langchain-Chatchat 也存在这个问题

照他这个说法

:用不用 GPU 要看你模型加载框架如何设置。

那就是ollama版本的问题了吗???

可以换旧版本的ollama试试,再旧也不能低于0.1.3

我不知道是不是 Ollama 的 Bug,打算看一下 GitHub 的 Issues。

我测试了下,从ollama0.1.3开始试验,几乎都是一样的速度,后来发现不是ollama的问题。

是因为设置里添加的某个知识库的问题,这个知识库是web方式抓取的,有1万多个文档,只要添加上这个就非常慢,索性把它去掉勾选了,速度几乎就是秒答了。

我分析是这个web方式抓取的,不如直接导入的文档处理的好,导致检索速度大大降低。