玉树

2

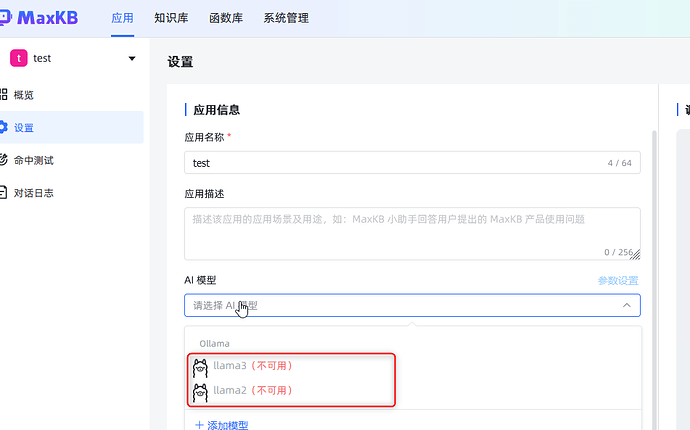

在【系统管理】-【模型设置】页面把llama2和llama3的配置信息都重新编辑并保存下,看是否可以校验成功。

发现如图的报错,这个maxkb必须要联网吗?我暂时没有配置网络代理

玉树

4

是的,平台本身不会自带各类模型,你对接的也不是本地模型吧?不是本地模型就一定需要网络对接的。

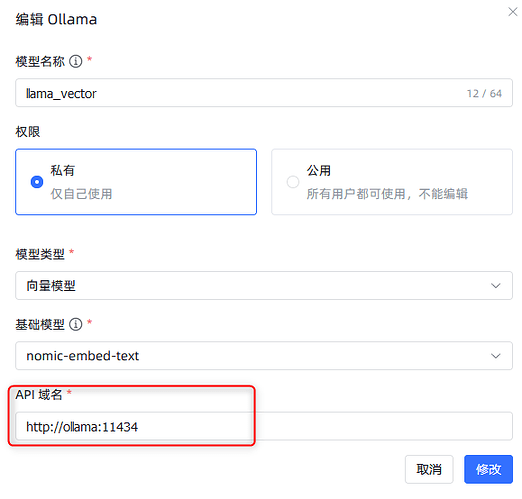

是本地部署的ollama,是跟maxkb在同一台服务器上

玉树

6

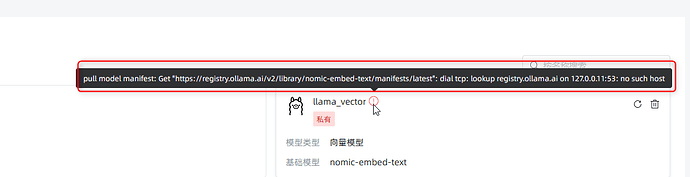

你对接本地的ollama是成功的,因为ollama已经开始下载nomic-embed-text模型了,这个错误就是在下载这个模型的时候识别不到下载地址。

现在给maxkb容器配置了网络代理,直接配置千问模型成功了,可是这个ollama还是报错。

还有一个问题:配置了网络代理后,知识库的向量化总是失败,配置之前是ok的

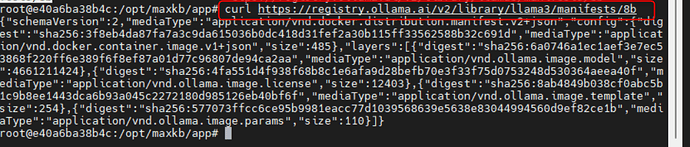

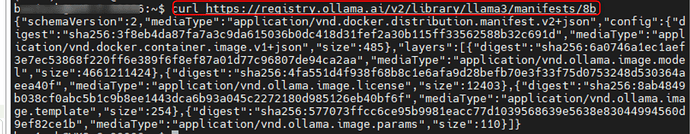

在maxkb容器内部curl报错的网址,是ok的,为何页面上就报这个错误呢?

玉树

9

直接在服务器上面curl试试呢,下载动作是ollama进行的,ollama应该是在服务器上非容器里。

linux本机里curl,也是ok的

还有上一个问题也帮忙看下哦,怎么容器配置了proxy代理后,向量化总是失败,配置proxy之前是好的

玉树

11

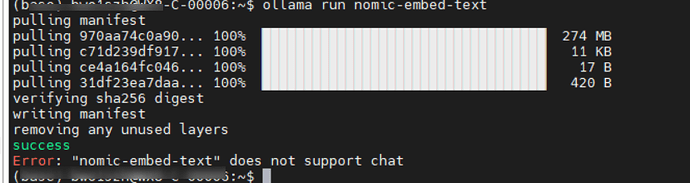

linux上面用ollama run nomic-embed-text看看ollama本身能不能下载?

顺带向量不了的问题看一下/opt/maxkb/logs下面的日志。

linux上可以正常下载nomic-embed-text

另外,没有/opt/maxkb/logs这个文件或路径

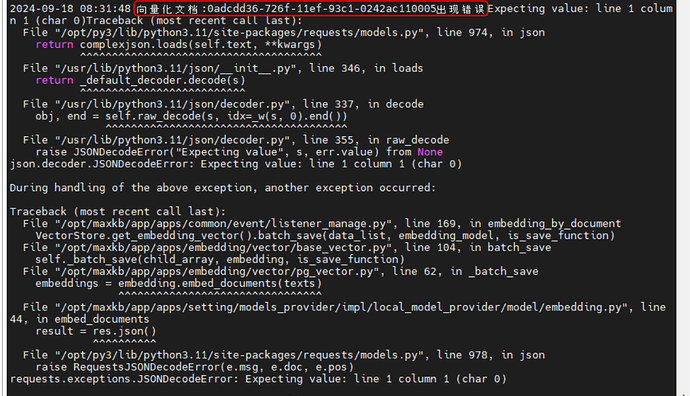

给容器配置代理后,向量化失败log如上图,但是不配置网络代理可以正常向量化。

配置代理后,向量化失败。这个应该是1.5.1这个版本的bug,我退到1.4.1后,配置代理也可以正常向量化。请加快解决这个bug哦,还是想用你们的新版本,有函数库功能哦,谢谢~~~

玉树

15

麻烦在这里提交一个issue,需要仔细描述下配置代理的方式。