- 想使用maxkb部署一个公司内部使用,用于查询内部资料的【知识库】,如果知识库没有,则回复不存在。

- 很疑惑,我的【应用】必须配置一个大语言模型吗?我只需要分析【知识库】中的内容即可。

- 我的具体配置如下:

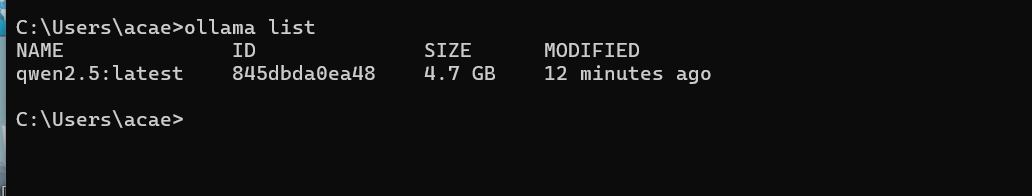

目前我安装的ollama ,使用了qwen2.5模型库

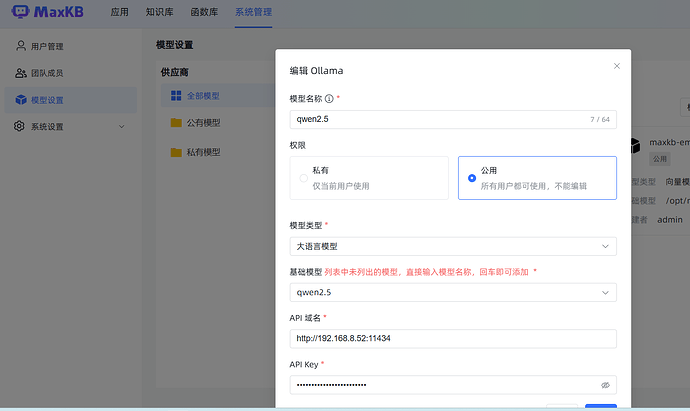

下面是maxkb模型设置

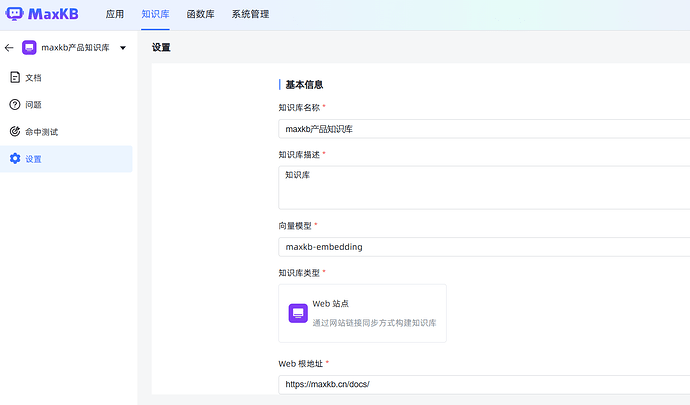

以下是知识库配置

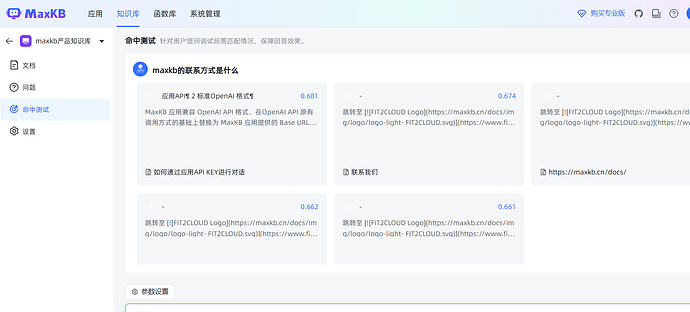

在【知识库】测试,是可以正常回复的

以下是【应用】配置

【命中测试】功能也正常

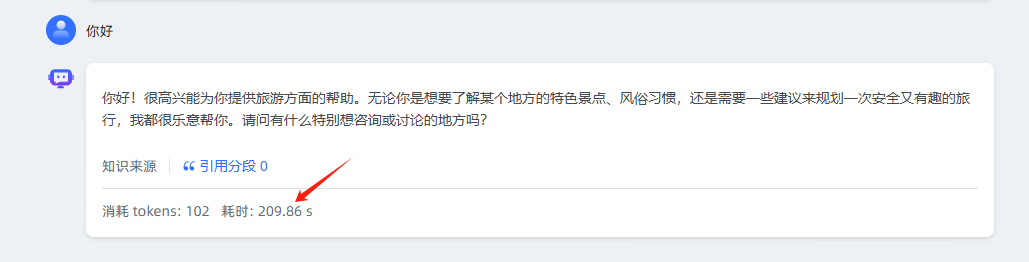

但是在【演示】功能界面,我提问就一直显示回答中,我分别在linux和我自己的windows电脑部署过ollama进行测试,都是一样的效果